hace 11 meses

- Introducción a la Implementación de Regresión Logística Multiclase con Scikit-Learn

- Elección de Técnica en Regresión Logística Multiclase

- Modelos Lineales y sus Limitaciones

- Función Sigmoide y Multiclase

- Implementación de Softmax en Scikit-Learn

- Ejemplo Práctico con el Dataset de Iris

- Visualización de Regiones de Decisión

- Predicción de Probabilidades

Introducción a la Implementación de Regresión Logística Multiclase con Scikit-Learn

[Música] ¡Bienvenidos! Hoy exploraremos cómo llevar a cabo una implementación optimizada de la regresión logística utilizando Scikit-Learn, una herramienta poderosa que soporta configuraciones multiclase de manera automática.Elección de Técnica en Regresión Logística Multiclase

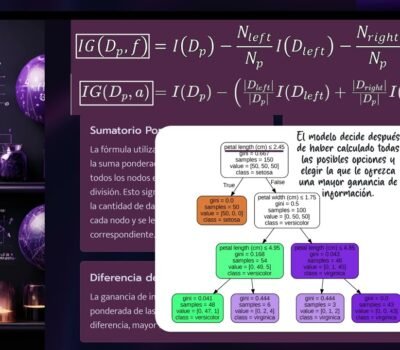

Para clasificaciones multiclase en las versiones más recientes de Scikit-Learn, la selección entre la técnica multinomial y la técnica OVR (One-vs-Rest) se maneja automáticamente. Sin embargo, por consistencia con videos anteriores, seguimos utilizando OVR por el momento. Es crucial entender la técnica multinomial y su relación con la función Softmax, fundamental en arquitecturas modernas como los Transformers.

Modelos Lineales y sus Limitaciones

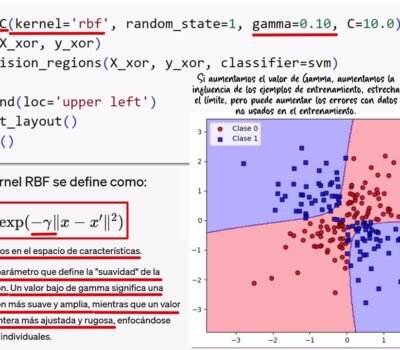

Hemos visto que modelos como Perceptrón o Adaline pueden implementar clasificaciones multiclase con OVR, pero enfrentan limitaciones cuando las clases no son linealmente separables. Esto impide una delimitación clara de las regiones de decisión, lo que se traduce en problemas de convergencia y dificultades para manejar clases complejas. Aquí radica la importancia de modelos más flexibles capaces de gestionar separaciones no lineales.

Función Sigmoide y Multiclase

Para clasificaciones binarias, la regresión logística utiliza la función sigmoide, transformando los valores de una regresión lineal en un resultado entre 0 y 1 - ideal para probabilidades. Sin embargo, esta función no es adecuada para multiclase ya que no garantiza que la suma total de todas las probabilidades predichas sea uno, problema que sí solventa la función Softmax.

Implementación de Softmax en Scikit-Learn

La función Softmax toma un vector de valores reales transformándolos en una distribución de probabilidades, donde la suma total debe ser igual a uno. Esto se vió aplicado en arquitecturas como Transformer. En el contexto de Scikit-Learn, la función Softmax es usada en la regresión logística multinomial para convertir la salida lineal en probabilidades bien distribuidas.

Ejemplo Práctico con el Dataset de Iris

Vamos a utilizar la clase LogisticRegression de Scikit-Learn para entrenar nuestro modelo en el dataset de flores Iris. Explicaremos cómo los parámetros pasados a la constructora, como la regularización inversa (C) y el solver, influyen en el comportamiento del modelo durante el entrenamiento.

Visualización de Regiones de Decisión

Utilizaremos la función plot_decision_regions para visualizar cómo el modelo de regresión logística divide el espacio dependiendo de cada clase. Este paso es clave para entender cómo el modelo maneja los datos de entrenamiento y prueba, ayudando a prevenir el sobreajuste.

Predicción de Probabilidades

Finalizaremos utilizando el método predict_proba para obtener las probabilidades predichas por nuestro modelo para muestras específicas del dataset de prueba. Esto es esencial para entender cómo el modelo calcula la probabilidad de que nuevas observaciones pertenezcan a ciertas clases.

============================================

Si quieres conocer otros artículos parecidos a Descubre Cómo Entrenar un Modelo de Regresión Logística en scikit-learn para Ciencia de Datos y ML puedes visitar la categoría Jesús Conde.

Deja una respuesta