hace 1 año · Actualizado hace 11 meses

- Cómo evitar sesgos discriminatorios al utilizar ChatGPT

- El sesgo y la discriminación pueden ser problemas en los modelos de IA como ChatGPT. Aquí hay algunas medidas que puedes tomar para evitar el sesgo discriminatorio:

- 1. Entender el sesgo discriminatorio en los modelos de IA

- 2. Realizar una selección de datos equilibrada y no discriminatoria

- 3. Limpiar los datos de sesgos discriminatorios

- 4. Implementar medidas de transparencia para prevenir el sesgo discriminatorio

- 5. Promover la diversidad en los equipos de desarrollo para combatir el sesgo discriminatorio

- 6. Implementar pruebas y evaluaciones rigurosas para detectar sesgos discriminatorios

- 7. Mantener una mejora continua y retroalimentación para prevenir la discriminación

- Preguntas frecuentes sobre el sesgo y la discriminación en los modelos de IA:

- Fuentes:

- Descubre el poder de la Inteligencia Artificial aplicada de manera práctica en el marketing con el uso de ChatGPT.

Cómo evitar sesgos discriminatorios al utilizar ChatGPT

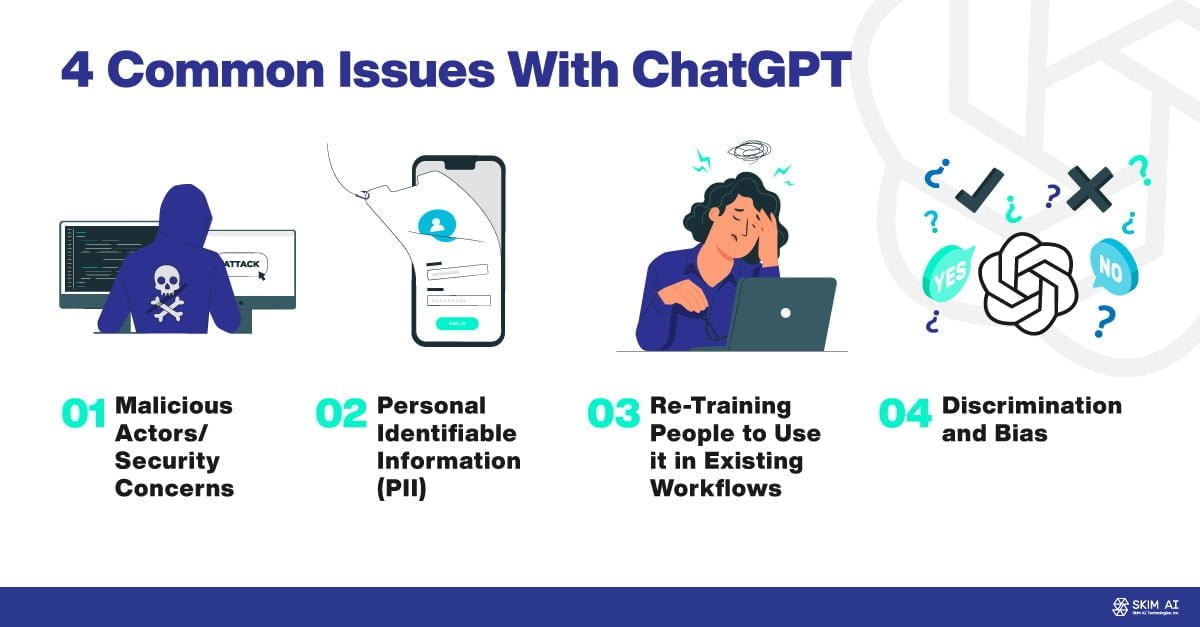

El sesgo y la discriminación son problemas comunes en los modelos de IA como ChatGPT. Para evitar estos problemas, es crucial comprender el sesgo discriminatorio en los modelos de IA y cómo se manifiesta en las respuestas generadas. También es fundamental tener una selección de datos equilibrada y representativa de la diversidad de la población, así como limpiar los datos de sesgos y aplicar técnicas de reequilibrio. La transparencia en el uso de modelos de IA, la promoción de la diversidad en los equipos de desarrollo, las pruebas y evaluaciones rigurosas, y el mantenimiento de una mejora continua y retroalimentación también son fundamentales para evitar el sesgo discriminatorio.

El sesgo y la discriminación pueden ser problemas en los modelos de IA como ChatGPT. Aquí hay algunas medidas que puedes tomar para evitar el sesgo discriminatorio:

1. Entender el sesgo discriminatorio en los modelos de IA

Los modelos de IA, como ChatGPT, aprenden a partir de los datos con los que se les entrenan. Si estos datos contienen sesgos discriminatorios, el modelo puede replicarlos en sus respuestas. Es esencial comprender que los sesgos discriminatorios pueden manifestarse de diferentes formas, como la discriminación racial, de género o de cualquier otro tipo. Para evitar problemas de sesgo discriminatorio, es crucial analizar y comprender los datos de entrenamiento utilizados.

2. Realizar una selección de datos equilibrada y no discriminatoria

Una medida importante para evitar el sesgo discriminatorio en los modelos de IA es asegurarse de tener una selección de datos equilibrada y no discriminatoria, representativa de la diversidad de la población. Esto implica incluir datos de diferentes grupos étnicos, géneros, edades, orientaciones sexuales, entre otros. Al tener una muestra más amplia y variada, se reducen las posibilidades de sesgo discriminatorio en las respuestas generadas por el modelo.

3. Limpiar los datos de sesgos discriminatorios

Una forma de abordar el sesgo discriminatorio en los modelos de IA es realizar una limpieza exhaustiva de los datos de entrenamiento. Esto implica identificar y eliminar cualquier contenido discriminatorio o sesgado. Además, se pueden aplicar técnicas de reequilibrio para garantizar que el modelo tenga una visión más justa y equitativa. La limpieza de datos es un proceso esencial para minimizar el sesgo discriminatorio en los modelos de IA y fomentar una mayor inclusión.

4. Implementar medidas de transparencia para prevenir el sesgo discriminatorio

La transparencia en el uso de modelos de IA es crucial para prevenir y abordar el sesgo discriminatorio. Proporcionar información sobre cómo se realiza el entrenamiento del modelo, qué datos se utilizan y cómo se manejan los posibles sesgos es fundamental. Esto fomenta la confianza y permite que los usuarios comprendan mejor la fiabilidad de las respuestas generadas. La transparencia en la IA es una estrategia efectiva para evitar problemas de sesgo discriminatorio.

5. Promover la diversidad en los equipos de desarrollo para combatir el sesgo discriminatorio

Un enfoque clave para evitar el sesgo discriminatorio en los modelos de IA es contar con equipos de desarrollo diversos y multidisciplinarios. Al incluir diferentes perspectivas y experiencias, se puede obtener una visión más amplia y evitar que los sesgos discriminatorios se introduzcan involuntariamente en los modelos. La diversidad en los equipos de desarrollo permite tener una mayor sensibilidad y comprensión de las posibles implicaciones éticas y sociales de los modelos de IA.

6. Implementar pruebas y evaluaciones rigurosas para detectar sesgos discriminatorios

Las pruebas y evaluaciones rigurosas son esenciales para identificar y abordar el sesgo discriminatorio en los modelos de IA. Se deben realizar pruebas exhaustivas en diferentes escenarios y con diversos grupos de usuarios para analizar posibles respuestas inapropiadas o discriminatorias. Además, se pueden implementar métricas específicas para evaluar la diversidad y equidad en las respuestas generadas. Estas pruebas permiten detectar y corregir posibles sesgos discriminatorios antes de implementar los modelos de IA en entornos reales.

7. Mantener una mejora continua y retroalimentación para prevenir la discriminación

La IA es un campo en constante evolución, y es crucial que los desarrolladores y expertos en IA estén comprometidos con la mejora continua y la retroalimentación. Escuchar las preocupaciones y críticas de los usuarios y la comunidad en general ayudará a identificar posibles sesgos discriminatorios en los modelos de IA y tomar medidas correctivas. La retroalimentación constante es esencial para mantener la calidad y la imparcialidad de los modelos de IA.

Preguntas frecuentes sobre el sesgo y la discriminación en los modelos de IA:

1. ¿Qué es el sesgo en los modelos de IA?

El sesgo en los modelos de IA se refiere a la tendencia o inclinación hacia una respuesta o resultado específico basado en los datos de entrenamiento. Puede manifestarse como prejuicios o discriminación hacia determinados grupos o características.

2. ¿Por qué es importante abordar el sesgo y la discriminación en los modelos de IA?

Es importante abordar el sesgo y la discriminación en los modelos de IA para garantizar la equidad, la imparcialidad y evitar la perpetuación de prejuicios en las respuestas generadas. Además, la discriminación en la IA puede tener consecuencias negativas en diferentes aspectos sociales, como la toma de decisiones justas y las oportunidades equitativas.

3. ¿Cómo se puede detectar el sesgo en los modelos de IA?

La detección de sesgo en los modelos de IA puede realizarse a través de la evaluación de las respuestas generadas en diferentes escenarios y con muestras representativas. Se pueden utilizar métricas y pruebas específicas para identificar patrones de sesgo o discriminación en las respuestas generadas.

4. ¿Qué pasa si se identifica sesgo en un modelo de IA?

Si se identifica sesgo en un modelo de IA, es importante tomar medidas correctivas. Esto puede implicar reentrenar el modelo con datos más equilibrados y diversificados, corregir algoritmos o implementar técnicas de mitigación del sesgo. El objetivo es garantizar que el modelo genere respuestas justas, imparciales y no discriminatorias.

5. ¿Cómo se puede evitar la discriminación en los modelos de IA?

Para evitar la discriminación en los modelos de IA, es fundamental utilizar una selección de datos equilibrada y diversa, así como realizar una limpieza exhaustiva de los datos de entrenamiento. Además, se deben implementar medidas de transparencia, promover la diversidad en los equipos de desarrollo, realizar pruebas rigurosas y mantener una mejora continua a partir de la retroalimentación de los usuarios.

6. ¿Qué papel juegan los usuarios en la prevención de la discriminación en los modelos de IA?

Los usuarios juegan un papel importante en la prevención de la discriminación en los modelos de IA al proporcionar retroalimentación y reportar posibles respuestas sesgadas o discriminatorias. La participación activa de los usuarios contribuye a mejorar la calidad y equidad de los modelos de IA.

7. ¿Cuál es la responsabilidad de los desarrolladores en la mitigación del sesgo y la discriminación en los modelos de IA?

Los desarrolladores tienen la responsabilidad de garantizar que los modelos de IA sean justos, imparciales y no discriminatorios. Esto implica implementar medidas de mitigación del sesgo, como selección de datos equilibrada, limpieza de datos, pruebas rigurosas y transparencia en el uso de los modelos.

Fuentes:

Analytics Insight

VentureBeat

Builtin

============================================

Descubre el poder de la Inteligencia Artificial aplicada de manera práctica en el marketing con el uso de ChatGPT.

Descubre cómo utilizar ChatGPT para optimizar tus estrategias de marketing y obtener resultados sorprendentes. Aprende a crear contenido atractivo, interactuar con clientes de manera personalizada y aumentar tus ventas con este revolucionario sistema. Si deseas profundizar en el tema y aprovechar al máximo esta tecnología, te invitamos a conocer nuestro curso especializado. Descubre cómo la inteligencia artificial puede transformar tu negocio y llevarte al siguiente nivel en el mundo del marketing.

¡NO DEJES PASAR ESTA OPORTUNIDAD CON EL 50% DE DESCUENTO SOLO AQUÍ!

Si quieres conocer otros artículos parecidos a Cómo evitar sesgos y discriminación al utilizar ChatGPT puedes visitar la categoría ChatGPT.

Deja una respuesta