hace 11 meses

- Introducción a los Árboles de Decisión

- Implementación de Árboles de Decisión con Python

- Entrenamiento y Visualización del Modelo

- Introducción a los Bosques Aleatorios

- Implementación de Bosques Aleatorios con Python

- Comparación de Árboles de Decisión y Bosques Aleatorios

- Conclusión: Beneficios y Transparencia de los Modelos

Introducción a los Árboles de Decisión

Los árboles de decisión son un modelo de aprendizaje automático que divide el espacio de características en rectángulos para hacer predicciones. Al crear un árbol de decisión, es crucial evitar una profundidad excesiva, ya que esto puede llevar a un sobreajuste del modelo. Se recomienda usar una profundidad máxima de cuatro y la impureza de Gini como criterio de impureza predeterminado.

Implementación de Árboles de Decisión con Python

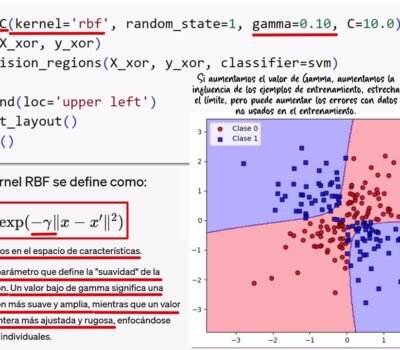

Para construir un árbol de decisión en python, utilizamos la biblioteca scikit-learn. El proceso comienza importando DecisionTreeClassifier y configurando el modelo con parámetros específicos. En este ejemplo, el criterio Gini es utilizado para evaluar las impurezas y max_depth=4 para limitar la profundidad del árbol. También se establece random_state=1 para asegurar la reproductibilidad del modelo.

Entrenamiento y Visualización del Modelo

El modelo se entrena con un conjunto de datos (en este caso, el dataset Iris) utilizando las matrices x_train y y_train para las características y etiquetas respectivamente. Para visualizar cómo el modelo clasifica las diferentes regiones, se utiliza la función plot_decision_regions, mostrando los límites de decisión precisos aunque no perfectos.

Introducción a los Bosques Aleatorios

Los bosques aleatorios son un avance sobre los árboles de decisión individuales que ayudan a reducir la varianza y aumentar la estabilidad de las predicciones mediante la creación de múltiples árboles y promediando sus predicciones. Se muestra cómo este método puede manejar mejor el sobreajuste y generalizar más efectivamente sobre datos no vistos previamente.

Implementación de Bosques Aleatorios con Python

Usando scikit-learn, importamos RandomForestClassifier desde sklearn.ensemble. Configuramos el clasificador con n_estimators=25 para definir el número de árboles en el bosque y otros parámetros, como random_state y n_jobs, para mejorar la eficiencia del entrenado. Al igual que con los árboles de decisión, utilizamos plot_decision_regions para visualizar las divisiones del espacio de características.

Comparación de Árboles de Decisión y Bosques Aleatorios

Se discuten las diferencias entre un árbol de decisión y un bosque aleatorio, incluyendo cómo manejan problemas como la varianza y el sesgo. Mientras que los árboles de decisión pueden tener fronteras de decisión abruptas y ser susceptibles a errores de clasificación, los bosques aleatorios ofrecen fronteras más suaves y son menos propensos al sobreajuste.

Conclusión: Beneficios y Transparencia de los Modelos

Finalmente, se discute la transparencia de los árboles de decisión en comparación con los bosques aleatorios. Aunque los árboles de decisión son más fáciles de interpretar, los bosques aleatorios, siendo un ejemplo de aprendizaje conjunto (ensemble learning), ofrecen una mejora en la generalización pero a expensas de una menor transparencia debido a la agregación de múltiples árboles.

============================================

Si quieres conocer otros artículos parecidos a 035.- Descubriendo los Secretos de la Ciencia de Datos para ML: Explorando los Misteriosos Bosques Aleatorios puedes visitar la categoría Jesús Conde.

Deja una respuesta